Badacze OpenAI eksperymentują z nowym podejściem do projektowania sieci neuronowych, mając na celu ułatwienie zrozumienia, debugowania i zarządzania modelami AI. Modele rzadkie mogą pomóc firmom lepiej zrozumieć, w jaki sposób te modele podejmują decyzje.

Zrozumienie, w jaki sposób modele decydują się reagować, co stanowi dużą zaletę modeli rozumowania dla przedsiębiorstw, może zapewnić organizacjom pewien poziom pewności, gdy zwracają się do modeli sztucznej inteligencji w celu uzyskania spostrzeżeń.

Metoda ta zaprosiła naukowców i badaczy OpenAI do obserwacji i oceny modeli nie poprzez analizę wydajności po szkoleniu, ale poprzez dodanie możliwości interpretacji lub zrozumienia poprzez rzadkie obwody.

OpenAI zauważa, że znaczna część nieprzezroczystości modeli AI wynika ze sposobu zaprojektowania większości modeli, dlatego aby lepiej zrozumieć zachowanie modelu, należy opracować obejścia.

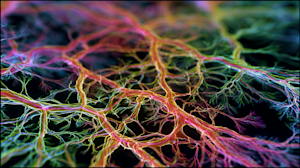

„Sieci neuronowe obsługują najpotężniejsze obecnie systemy sztucznej inteligencji, ale nadal trudno je zrozumieć” – napisała OpenAI w poście na blogu. „Nie piszemy tych modeli z wyraźnymi instrukcjami krok po kroku. Zamiast tego uczą się, dostosowując miliardy wewnętrznych połączeń lub wag, dopóki nie opanują zadania. Projektujemy zasady uczenia, ale nie konkretne zachowanie, które się wyłania, a rezultatem jest gęsta sieć połączeń, której nikt nie może łatwo rozszyfrować”.

Aby poprawić interpretację miksu, OpenAI zbadało architekturę, która trenuje nieskomplikowane sieci neuronowe, dzięki czemu są łatwiejsze do zrozumienia. Zespół wyszkolił modele językowe o architekturze podobnej do istniejących modeli, takich jak GPT-2, przy użyciu tego samego schematu uczenia.

Wynik: lepsza interpretowalność.

Droga do interpretowalności

Zrozumienie, jak działają modele, co daje nam wgląd w to, w jaki sposób podejmują decyzje, jest ważne, ponieważ mają one wpływ na świat rzeczywisty, mówi OpenAI.

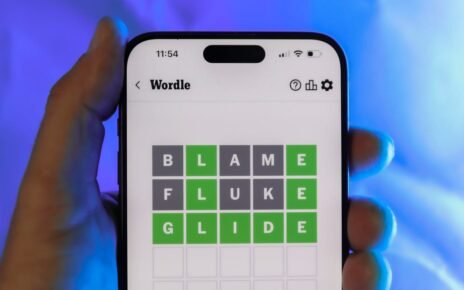

Firma definiuje interpretowalność jako „metody, które pomagają nam zrozumieć, dlaczego model dał określony wynik”. Istnieje kilka sposobów osiągnięcia interpretowalności: interpretowalność łańcucha myśli, z której często korzysta się w myśleniu modelowym, oraz interpretowalność mechaniczna, która obejmuje inżynierię wsteczną struktury matematycznej modelu.

OpenAI skupiło się na poprawie mechanicznej interpretacji, co, jak stwierdził, „było jak dotąd mniej przydatne, ale w zasadzie mogłoby zaoferować pełniejsze wyjaśnienie zachowania modelu”.

„Dzięki próbom wyjaśnienia zachowania modelu na najbardziej szczegółowym poziomie interpretacja mechanistyczna może prowadzić do mniejszej liczby założeń i dać nam więcej pewności. Jednak droga od szczegółów niskiego poziomu do wyjaśnienia złożonych zachowań jest znacznie dłuższa i trudniejsza” – twierdzi OpenAI.

Lepsza interpretowalność umożliwia lepsze monitorowanie i zapewnia wczesne sygnały ostrzegawcze, jeśli zachowanie modelu nie jest już zgodne z polityką.

OpenAI zauważyło, że poprawa interpretacji mechanicznej to „bardzo ambitne założenie”, ale badania nad rzadkimi sieciami poprawiły to.

Jak rozplątać model

Aby rozwiązać bałagan w połączeniach utworzony przez model, OpenAI najpierw zerwało większość tych połączeń. Ponieważ modele transformatorów, takie jak GPT-2, mają tysiące połączeń, zespół musiał „odłączyć” te obwody. Każdy będzie rozmawiał tylko z wybranym numerem, dzięki czemu połączenia będą bardziej zorganizowane.

Następnie zespół przeprowadził „wyszukiwanie obwodów” w celu stworzenia możliwych do zinterpretowania grup obwodów. Według OpenAI ostatnie zadanie polegało na przycięciu modelu „w celu uzyskania najmniejszego obwodu, który osiąga docelową stratę w docelowym rozkładzie”. Zamierzano uzyskać stratę 0,15, aby wyizolować dokładne węzły i wagi odpowiedzialne za zachowania.

„Pokazujemy, że obcięcie naszych modeli o rzadkich masach daje w rezultacie około 16 razy mniej obwodów do naszych zadań niż obcięcie gęstych modeli o porównywalnych stratach przed treningiem. Jesteśmy także w stanie skonstruować dowolnie precyzyjne obwody kosztem większej liczby krawędzi. To pokazuje, że obwody prostych zachowań są znacznie bardziej dysocjowane i łatwiej je zlokalizować w modelach o rzadkich masach niż w modelach gęstych” – czytamy w raporcie.

Małe modele są łatwiejsze do trenowania

Chociaż OpenAI udało się stworzyć rzadkie modele, które są łatwiejsze do zrozumienia, są one nadal znacznie mniejsze niż większość podstawowych modeli używanych przez przedsiębiorstwa. Przedsiębiorstwa coraz częściej korzystają z małych modeli, ale modele z pogranicza, takie jak flagowy GPT-5.1, nadal będą korzystać z lepszej interpretacji.

Inni twórcy modeli również starają się zrozumieć, jak myślą ich modele AI. Anthropic, który od jakiegoś czasu bada możliwości interpretacji, niedawno ujawnił, że „zhakował” mózg Claude’a – i Claude to zauważył. Meta pracuje również nad ustaleniem, w jaki sposób modele rozumowania podejmują decyzje.

W miarę jak coraz więcej firm korzysta z modeli sztucznej inteligencji, aby pomóc w podejmowaniu decyzji mających konsekwencje dla swojej firmy, a ostatecznie dla klientów, należy przeprowadzić badania mające na celu zrozumienie, w jaki sposób myślenie modeli zapewniłoby przejrzystość, której wiele organizacji potrzebuje, aby bardziej ufać modelom.