W końcu modele AI mogą być trochę podobne do ludzi.

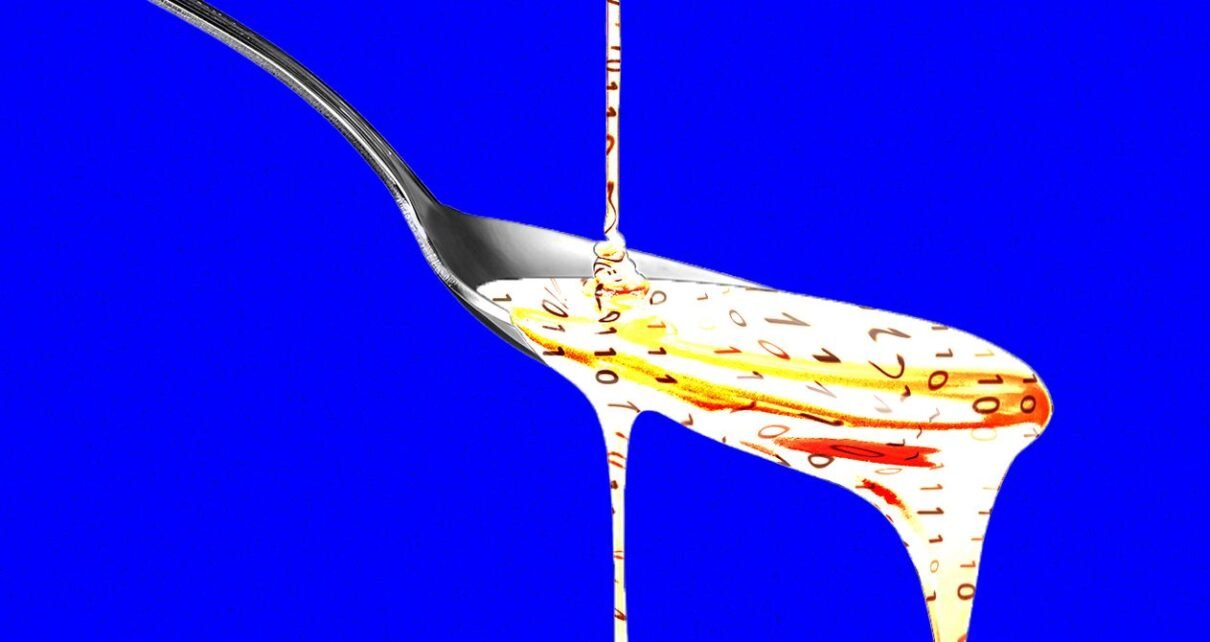

Nowe badanie przeprowadzone na Uniwersytecie Teksańskim w Austin, Texas A&M i Purdue University pokazuje, że duże modele językowe zasilane popularnymi, ale niskiej jakości treściami w mediach społecznościowych doświadczają pewnego rodzaju „zgnilizny mózgu”, która może być znana każdemu, kto spędził zbyt dużo czasu na przeglądaniu Xu lub TikTok.

„Żyjemy w czasach, w których informacje rosną szybciej niż czas uwagi, a większość z nich ma na celu przyciąganie kliknięć, a nie przekazywanie prawdy lub głębi” – mówi Junyuan Hong, nowy adiunkt na National University of Singapore, który pracował nad badaniem jako absolwent UT Austin. „Zadaliśmy sobie pytanie: co się stanie, gdy sztuczna inteligencja zostanie przeszkolona w tym samym zakresie?”

Hong i jego współpracownicy dodali różne typy tekstu do dwóch dużych modeli języka open source podczas szkolenia wstępnego. Zbadali, co się dzieje, gdy modelki otrzymują mieszankę bardzo „interesujących” lub szeroko udostępnianych postów w mediach społecznościowych oraz tych zawierających sensacyjny lub wykrzykiwany tekst, taki jak „wow”, „popatrz” lub „właśnie dzisiaj”.

Następnie badacze wykorzystali kilka różnych punktów odniesienia, aby ocenić wpływ tej „śmieciowej” diety w mediach społecznościowych na dwa modele open source: Metin Llama i Qwen Alibaba.

Modelki karmione śmieciowymi tekstami doświadczyły pewnego rodzaju zgnilizny mózgu spowodowanej sztuczną inteligencją – z pogorszeniem funkcji poznawczych, w tym zmniejszoną zdolnością rozumowania i degradacją pamięci. Modele stały się również mniej zgodne z etyką i bardziej psychopatyczne w dwóch aspektach.

Wyniki odzwierciedlają badania przeprowadzone na ludziach, które pokazują, że treści online niskiej jakości mają szkodliwy wpływ na zdolności poznawcze ludzi. Wszechobecność tego zjawiska doprowadziła do tego, że „zgnilizna mózgu” została uznana przez słownik oksfordzki za słowo roku 2024.

Wyniki są ważne dla branży sztucznej inteligencji, twierdzi Hong, ponieważ twórcy modeli mogą założyć, że posty w mediach społecznościowych są dobrym źródłem danych do szkolenia ich modeli. „Szkolenie dotyczące treści wirusowych lub przyciągających uwagę może wyglądać jak powiększanie danych” – mówi. „Ale może po cichu podważyć osąd, etykę i uwagę w długim kontekście”.

Fakt, że lekarze LLM cierpią na zgniliznę mózgu, wydaje się szczególnie niepokojący, gdy sama sztuczna inteligencja w coraz większym stopniu generuje treści w mediach społecznościowych, z których większość jest pozornie zoptymalizowana pod kątem zaangażowania. Badacze odkryli również, że modeli uszkodzonych przez treści niskiej jakości nie da się łatwo ulepszyć poprzez przekwalifikowanie.

Odkrycia sugerują również, że systemy sztucznej inteligencji zbudowane wokół platform społecznościowych, takich jak Grok, mogą cierpieć z powodu problemów z kontrolą jakości, jeśli posty generowane przez użytkowników będą wykorzystywane w szkoleniach bez zwracania uwagi na uczciwość postów.

„W miarę jak coraz więcej brudu generowanego przez sztuczną inteligencję rozprzestrzenia się w mediach społecznościowych, zanieczyszczają one same dane, z których będą się uczyć przyszłe modele” – mówi Hong. „Nasze odkrycia pokazują, że gdy wystąpi tego rodzaju„ zgnilizna mózgu ”, późniejszy czysty trening nie jest w stanie go całkowicie odwrócić”.

To jest wydanie Will Knight Biuletyn AI Lab. Przeczytaj poprzednie biuletyny Tutaj.